Python网络爬虫基础知识

(一)发起HTTP/HTTPS请求

一:方法一:urllib

urllib是python内置的HTTP请求库,无需安装即可使用,它包含了4个模块:

request:它是最基本的http请求模块,用来模拟发送请求

error:异常处理模块,如果出现错误可以捕获这些异常

parse:一个工具模块,提供了许多URL处理方法,如:拆分、解析、合并等

robotparser:主要用来识别网站的robots.txt文件,然后判断哪些网站可以爬

快速爬取一个网页

import urllib.request as ur response=ur.urlopen("https://www.baidu.com") html=response.read().decode("utf-8") print(html)<html> <head> <script> location.replace(location.href.replace("https://","http://")); </script> </head> <body> <noscript><meta http-equiv="refresh" content="0;url=http://www.baidu.com/"></noscript> </body> </html>

1、urllib.request.urlopen()

urllib.request.urlopen(url,data=None,[timeout,],cafile=None,capath=None,cadefault=False,context=None)

urlopen()方法可传递参数:

url:网站地址,str类型,也可以是一个request对象

data:data参数是可选的,内容为字节流编码格式的即bytes类型,如果传递data参数,urlopen将使用Post方式请求

from urllib.request import urlopen

import urllib.parse

data = bytes(urllib.parse.urlencode({'word':'hello'}),encoding='utf-8') #data需要字节类型的参数,使用bytes()函数转换为字节,使用urllib.parse模块里的urlencode()方法来讲参数字典转换为字符串并指定编码

response = urlopen('http://httpbin.org/post',data=data)

print(response.read())#output

b'{

........

"form":{"word":"hello"}, #form字段表明模拟以表单的方法提交数据,post方式传输数据

"headers":{"Accept-Encoding":"identity",

.......}'timeout参数:用于设置超时时间,单位为秒,如果请求超出了设置时间还未得到响应则抛出异常,支持HTTP,HTTPS,FTP请求

import urllib.request

response=urllib.request.urlopen('http://httpbin.org/get',timeout=0.1) #设置超时时间为0.1秒,将抛出异常

print(response.read())#output

urllib.error.URLError: <urlopen error timed out>可以使用异常处理来捕获异常

import urllib.request

import urllib.error

import socket

try:

response=urllib.request.urlopen('http://httpbin.org/get',timeout=0.1)

print(response.read())

except urllib.error.URLError as e:

if isinstance(e.reason,socket.timeout): #判断对象是否为类的实例

print(e.reason) #返回错误信息#output

timed out其他参数:context参数,她必须是ssl.SSLContext类型,用来指定SSL设置,此外,cafile和capath这两个参数分别指定CA证书和它的路径,会在https链接时用到。

2.返回HTTPResponse对象

urlopen()方法返回一个HTTPResponse类型的对象,该对象包含的方法和属性:

方法:read()、readinto()、getheader(name)、getheaders()、fileno()

属性:msg、version、status、reason、bebuglevel、closed

import urllib.request

response=urllib.request.urlopen('https://www.python.org') #请求站点获得一个HTTPResponse对象

print(response.read().decode('utf-8')) #返回网页内容

print(response.getheader('server')) #返回响应头中的server值

print(response.getheaders()) #以列表元祖对的形式返回响应头信息

print(response.fileno()) #返回文件描述符

print(response.version) #返回版本信息

print(response.status) #返回状态码200,404代表网页未找到

print(response.debuglevel) #返回调试等级

print(response.closed) #返回对象是否关闭布尔值

print(response.geturl()) #返回检索的URL

print(response.info()) #返回网页的头信息

print(response.getcode()) #返回响应的HTTP状态码

print(response.msg) #访问成功则返回ok

print(response.reason) #返回状态信息3.构造Request对象

如果希望执行更为复杂的操作(如增加HTTP报头),则必须创建一个Request()对象作为urlopen()的参数。

urllib.request.Request(url,data=None,headers={},origin_req_host=None,unverifiable=False,method=None)

参数:

url:请求的URL,必须传递的参数,其他都是可选参数

data:上传的数据,必须传bytes字节流类型的数据,如果它是字典,可以先用urllib.parse模块里的urlencode()编码

headers:它是一个字典,传递的是请求头数据,可以通过它构造请求头,也可以通过调用请求实例的方法add_header()来添加

例如:修改User_Agent头的值来伪装浏览器,比如火狐浏览器可以这样设置:

{‘User-Agent’:’Mozilla/5.0 (compatible; MSIE 5.5; Windows NT)’}

origin_req_host:指请求方的host名称或者IP地址

unverifiable:表示这个请求是否是无法验证的,默认为False,如我们请求一张图片如果没有权限获取图片那它的值就是true

method:是一个字符串,用来指示请求使用的方法,如:GET,POST,PUT等

import urllib.request

import urllib.parse

url='http://www.itcast.cn'

header={"User-Agent":'Mozilla/5.0 (compatible; MSIE 5.5; Windows NT)'}

data=bytes(urllib.parse.urlencode({"name":"itcast"}).encode('utf-8'))

request=urllib.request.Request(url,headers=header,data=data)

response=urllib.request.urlopen(request)

print(response.read().decode("utf-8"))4.如何发送get请求?

如果使用urlopen()方法中的data属性发送的话属于POST请求,所有只能通过修改url的方式来发送GET请求,如:

word={"wd":"itcast"}

word=urllib.parse.urlencode(word)

new_url=url+"?"+word5.添加特定Headers

可以调用request.add_header(“Connection”,”keep-alive”)

可以调用request.get_header(header_name=”Connection”)

6.代理服务器

之前的urlopen()方法就是urllib提供的一个opener, 它是urllib.request.OpenerDirector类的对象。但urlopen()方法不支持代理,Cookie等其他的HTTP/HTTPS高级功能。所有需要自定义一个Opener,需要执行以下几步:

- 使用相关的Handler处理器创建特定功能的处理器对象

- 通过urllib.request.build_opener()方法创建自定义的opener对象

- 使用自定义的opener对象,调用open()方法发送请求

注意:如果想使用全局的opener发送请求的话,可以使用urllib2.install_opener()将自定义的opener对象定义为全局opener

import urllib.request

http_handler = urllib.request.HTTPHandler()

opener = urllib.request.build_opener(http_handler)

request=urllib.request.Request("http://itcast.cn")

response=opener.open(request)

print(response.read().decode("utf-8"))设置代理服务器

用户可以用urllib.request.ProxyHandler方法来设置代理服务器

from urllib.error import URLError

from urllib.request import ProxyHandler,build_opener

proxy_handler=ProxyHandler({

'http':'http://127.0.0.1:8888',

'https':'http://127.0.0.1:9999'

})

opener=build_opener(proxy_handler) #构造一个Opener

try:

response=opener.open('https://www.baidu.com')

print(response.read().decode('utf-8'))

except URLError as e:

print(e.reason)提供几个免费的代理网站:

- 西刺免费代理IP

- 快代理免费代理

- Proxy360代理

- 全网代理IP

获取网站的Cookies

#!/usr/bin/env python

#coding:utf8

import http.cookiejar,urllib.request

cookie=http.cookiejar.CookieJar() #实例化cookiejar对象

handler=urllib.request.HTTPCookieProcessor(cookie) #构建一个handler

opener=urllib.request.build_opener(handler) #构建Opener

response=opener.open('http://www.baidu.com') #请求

print(cookie)

for item in cookie:

print(item.name+"="+item.value)7.异常处理

urllib的error模块定义了由request模块产生的异常,如果出现问题,request模块便会抛出error模块中定义的异常。

1)URLError

URLError类来自urllib库的error模块,它继承自OSError类,是error异常模块的基类,由request模块产生的异常都可以通过捕获这个类来处理,它只有一个属性reason,即返回错误的原因

from urllib import request,error

try:

response=request.urlopen('https://hehe,com/index')

except error.URLError as e:

print(e.reason) #如果网页不存在不会抛出异常,而是返回捕获的异常错误的原因(Not Found)reason如超时则返回一个对象

import socket

import urllib.request

import urllib.error

try:

response=urllib.request.urlopen('https://www.baidu.com',timeout=0.001)

except urllib.error.URLError as e:

print(e.reason)

if isinstance(e.reason,socket.timeout):

print('time out')2)HTTPError

它是URLError的子类,专门用来处理HTTP请求错误,比如认证请求失败,它有3个属性:

code:返回HTTP的状态码,如404页面不存在,500服务器错误等

reason:同父类,返回错误的原因

headers:返回请求头

from urllib import request,error

try:

response=request.urlopen('http://cuiqingcai.com/index.htm')

except error.HTTPError as e: #先捕获子类异常

print(e.reason,e.code,e.headers,sep='\n')

except error.URLError as e: #再捕获父类异常

print(e.reason)

else:

print('request successfully')二:方法二:requests

requests是python实现的简单易用的HTTP库,使用起来比urllib简洁很多。因为是第三方库,所以使用前需要cmd安装:pip install requests

安装完成后import一下,正常则说明可以开始使用了。

1.发起请求

基本用法:requests.get()用于请求目标网站,类型是一个HTTPresponse类型

import requests

url="http://httpbin.org/get"

data={"keywords":"itcast"}

headers={"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36"}

response = requests.get(url,headers=headers,params=data)

print(response.text){

"args": {

"keywords": "itcast"

},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Host": "httpbin.org",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36"

},

"origin": "118.123.252.136, 118.123.252.136",

"url": "https://httpbin.org/get?keywords=itcast"

}还可以将参数放在url中发送get请求

import requests

response = requests.get(http://httpbin.org/get?name=gemey&age=22)

print(response.text)除了提出get请求,还可以发出以下几个请求:

requests.get('http://httpbin.org/get')

requests.post('http://httpbin.org/post')

requests.put('http://httpbin.org/put')

requests.delete('http://httpbin.org/delete')

requests.head('http://httpbin.org/get')

requests.options('http://httpbin.org/get')2.带参数的请求

1.URL参数

使用方法:

requests.get(url,params={'key1':'value1'},proxies=proxy)2.表单参数提交

Content-Type:application.x-www-form-urlencoded (表单默认的提交数据格式)

内容:key1=value1&key2=value2

requests.post(url,data={'key1':'value1','key2':'value2'},proxies=proxy)3.json参数提交

Content-Type: appliction/json (json数据格式)

内容:’{“key”:”value1”,”key2”:”value2”}’

requests.post(url,json={'key1':'value1','key2':'value2'},proxies=proxy)3.Response对象

import requests

response = requests.get('http://www.baidu.com')

print(response.status_code) # 打印状态码

print(response.url) # 打印请求url

print(response.headers) # 打印头信息

print(response.cookies) # 打印cookie信息

print(response.text) #以文本形式打印网页源码

print(response.content) #以字节流形式打印4.异常捕获

在你不确定会发生什么错误时,尽量使用try…except来捕获异常。所有的requests.exception:

import requests

from requests.exceptions import ReadTimeout,HTTPError,RequestException

try:

response = requests.get('http://www.baidu.com',timeout=0.5)

print(response.status_code)

except ReadTimeout:

print('timeout')

except HTTPError:

print('httperror')

except RequestException:

print('reqerror')requests库将常见的http错误打了一个包,就是exceptions,通过使用exceptions可以处理项目中各种异常

RequestException:

HTTPError(RequestException)

UnrewindableBodyError(RequestException)

RetryError(RequestException)

ConnectionError(RequestException) ProxyError(ConnectionError)

SSLError(ConnectionError)

ConnectTimeout(ConnectionError, Timeout)

Timeout(RequestException) ReadTimeout

URLRequired(RequestException)

TooManyRedirects(RequestException)

MissingSchema(RequestException, ValueError)

InvalidSchema(RequestException,ValueError)

InvalidURL(RequestException,ValueError)

InvalidHeader(RequestException,ValueError)

ChunkedEncodingError(RequestException)

StreamConsumedError(RequestException,TypeError)

ContentDecodingError(RequestException,BaseHTTPError)综合案例

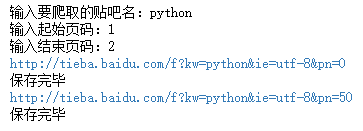

爬取“沈阳化工大学”贴吧的帖子回复数,主题和发帖人的信息

分析url地址:

http://tieba.baidu.com/f?kw=xxx&ie=utf-8&pn=0 #第一页的内容

http://tieba.baidu.com/f?kw=xxx&ie=utf-8&pn=50 #第二页的内容

http://tieba.baidu.com/f?kw=xxx&ie=utf-8&pn=100 #第三页的内容下面使用两种方法进行页面信息的爬取

1.使用requests方法

import requests

from lxml import etree as et

import json

class WebSpider(object):

def __init__(self):

self.keyword=input("输入要爬取的贴吧名:")

self.start_page=int(input("输入起始页码:"))

self.end_page=int(input("输入结束页码:"))

self.base_url="http://tieba.baidu.com/"

def load_page(self):

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36"

header={"User-Agent":user_agent}

for page in range(self.start_page,self.end_page+1):

#newkeyword=bytes(self.keyword).encode('utf-8')

new_url=self.base_url+"f?kw="+self.keyword+"&ie=utf-8&pn="+str((page-1)*50)

print(new_url)

response = requests.get(new_url,headers=header)

self.parse_page(response.text)

def parse_page(self,html):

html_new=html.replace(r'<!--','"').replace(r'-->','"')

root=et.HTML(html_new)

replynum=root.xpath("//ul[@id='thread_list']/li/div/div[1]//span/text()")

title=root.xpath("//ul[@id='thread_list']/li/div//a[@class='j_th_tit ']/text()")

#//ul[@id='thread_list']/li/div/div[2]/div[2]/div[1]/div/text()

url=root.xpath("//ul[@id='thread_list']/li/div//a[@class='j_th_tit ']/@href")

author=root.xpath("//ul[@id='thread_list']/li/div/div[2]/div[1]/div[2]/span[1]/@title")

self.append_page(replynum,title,url,author)

def append_page(self,replynum,title,url,author):

minsize=min(len(replynum),len(title),len(url),len(author))

items=[]

for i in range(minsize):

item={}

item["回复人数"]=replynum[i]

item["帖子题目"]=title[i]

item["帖子链接"]=self.base_url+url[i]

item["作者"]=author[i]

items.append(item)

self.save_json(items)

def save_json(self,items):

try:

for i in range(len(items)):

strr = json.dumps(items[i],ensure_ascii=False)

ff = open(self.keyword+".json","a",encoding='utf-8')

ff.write(strr)

ff.write("\n\n")

ff.close()

print("保存完毕")

except Exception as ex:

print("保存失败")

print(ex)

if __name__=="__main__":

spider = WebSpider()

spider.load_page()

2.使用urllib方法

代码主体与上面的一样,下面只列出不同的函数

import urllib.request

import urllib.parse

from lxml import etree as et

import json

def load_page(self):

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36"

header={"User-Agent":user_agent}

for page in range(self.start_page,self.end_page+1):

new_url=self.base_url+"f?kw="+self.keyword+"&ie=utf-8&pn="+str((page-1)*50)

print(new_url)

response = urllib.request.urlopen(urllib.request.Request(new_url,headers=header))

self.parse_page(response.read().decode("utf-8"))(二)爬取动态内容

提前安装好Selenium+chromedriver

一:入门操作

通常所有的操作与页面交互都将通过WebElement接口,常见的操作元素方法如下:

clear() #清除元素的内容

send_keys() #模拟按键输入

click() #点击元素

submit() #提交表单通过WebElement接口可以获取常用的值,这些值同样非常重要。

size #获取元素的尺寸

text #获取元素的文本 !!!

get_attribute(name) #获取属性值 !!!!!!

location #获取元素坐标,先找到要获取的元素,再调用该方法

page_source #返回页面源码 !!!

driver.title #返回页面标题 !!!

current_url #获取当前页面的URL !!!

is_displayed() #设置该元素是否可见

is_enabled() #判断元素是否被使用

is_selected() #判断元素是否被选中

tag_name #返回元素的tagName下面一次进行演示:

1.打开页面

from selenium import webdriver

browser=webdriver.Chrome()

#获取页面

browser.get("http://baidu.com/")这一步执行完会自动打开一个浏览器,浏览器中打开相应的百度页面,如果出现data;,这样的Tab,那么说明你的chrome浏览器和chromedriver的版本不一致造成的。

2.获取页面名为wrapper的id标签的文本内容

data=browser.find_element_by_id("wrapper").text

print(data)3.打印页面标题

print(browser.title)4.打印页面源代码(浏览器执行完后的页面)

print(browser.page_source)5.向表单添加内容,并进行搜索,截图

from selenium.webdriver.common.keys import Keys

import time

browser.get("http://baidu.com/")

browser.find_element_by_id("kw").send_keys(u"沈阳化工大学")

browser.find_element_by_id("kw").send_keys(Keys.RETURN)

time.sleep(2)

browser.save_screenshot("baidu.png")send_keys()方法的作用就是往页面元素上添加内容。此时,再次打开baidu.png时,可以看到“长城”已经添加带百度页面的搜索框中,并截下图了。

6.模拟点击页面上的按钮

import time

browser.get("http://baidu.com/")

browser.find_element_by_id("kw").send_keys(u"沈阳化工大学")

browser.find_element_by_id("su").click()

time.sleep(2)

browser.save_screenshot("baidu1.png")结果同上图一样

7.调用键盘操作Keys包

前面讲述了鼠标操作,现在讲述键盘操作。在webdriver的Keys类中提供了键盘所有的按键操作,当然也包括一些常见的组合键操作如Ctrl+A(全选)、Ctrl+C(复制)、Ctrl+V(粘贴)。更多键参考官方文档对应的编码。

send_keys(Keys.ENTER) #按下回车键

send_keys(Keys.TAB) #按下Tab制表键

send_keys(Keys.SPACE) #按下空格键space

send_keys(Kyes.ESCAPE) #按下回退键Esc

send_keys(Keys.BACK_SPACE) #按下删除键BackSpace

send_keys(Keys.SHIFT) #按下shift键

send_keys(Keys.CONTROL) #按下Ctrl键

send_keys(Keys.ARROW_DOWN) #按下鼠标光标向下按键

send_keys(Keys.CONTROL,'a') #组合键全选Ctrl``+``A

send_keys(Keys.CONTROL,'c') #组合键复制Ctrl``+``C

send_keys(Keys.CONTROL,'x') #组合键剪切Ctrl``+``X

send_keys(Keys.CONTROL,'v') #组合键粘贴Ctrl``+``Vfrom selenium.webdriver.common.keys import Keys通过模拟【Ctrl+A】键全选输入框内容

browser.find_element_by_id("kw").send_keys(Keys.CONTROL,'a')通过模拟【Ctrl+C】键复制输入框内容

browser.find_element_by_id("kw").send_keys(Keys.CONTROL,'c')通过模拟【Enter】键复制输入框内容

browser.find_element_by_id("kw").send_keys(u"沈阳化工大学")

browser.find_element_by_id("kw").send_keys(Keys.RETURN)8.清除输入框内容

browser.find_element_by_id("kw").clear()9.提交表单

driver.find_element_by_id("loginBtn").click()

driver.find_element_by_id("loginBtn").submit()10.获取当前页面的Cookie

browser.get_cookies()11.获取当前URL

browser.current_url12.关闭

browser.close()#关闭当前页面,如果只有一个页面,关闭浏览器

browser.quit()#关闭浏览器二:定位UI元素

这里有各种策略用于定位网页中的元素(locate elements),你可以选择最适合的方案,Selenium提供了一下方法来定义一个页面中的元素:

1.查找单个元素

find_element_by_id

find_element_by_name

find_element_by_xpath

find_element_by_link_text #根据链接文本定位到页面元素

find_element_by_partial_link_text#根据部分链接文本定位到页面元素

find_element_by_tag_name

find_element_by_class_name

find_element_by_css_selector#在这个函数中写选择器语句,比如:“#food span.dairy.aged”2.查找多个元素

下面是查找多个元素(这些方法将返回一个列表):

find_elements_by_name

find_elements_by_xpath

find_elements_by_link_text

find_elements_by_partial_link_text

find_elements_by_tag_name

find_elements_by_class_name

find_elements_by_css_selector3.示例

常用方法是通过xpath相对路径进行定位,同时CSS也是比较好的方法。举例:

<html>

<body>

<form id="loginForm">

<input name="username" type="text" />

<input name="password" type="password" />

<input name="continue" type="submit" value="Login" />

<input name="continue" type="button" value="Clear" />

</form>

</body>

<html>定位username元素的方法如下:

username = driver.find_element_by_xpath("//form[input/@name='username']")

username = driver.find_element_by_xpath("//form[@id='loginForm']/input[1]")

username = driver.find_element_by_xpath("//input[@name='username']") [1] 第一个form元素通过一个input子元素,name属性和值为username实现

[2] 通过id=loginForm值的form元素找到第一个input子元素

[3] 属性名为name且值为username的第一个input元素

三:鼠标操作

在现实的自动化测试中关于鼠标的操作不仅仅是click()单击操作,还有很多包含在ActionChains类中的操作。如下:

click(elem) #鼠标点击元素elem

context_click(elem) #右击鼠标点击元素elem,另存为等行为

double_click(elem) #双击鼠标点击元素elem,地图web可实现放大功能

drag_and_drop(source,target) #拖动鼠标,源元素按下左键移动至目标元素释放

move_to_element(elem) #鼠标移动到一个元素上

click_and_hold(elem) #按下鼠标左键在一个元素上并保持住

perform() #在通过调用该函数执行ActionChains中存储行为举例如下图所示,获取通过鼠标右键另存为百度图片logo。代码:

import time

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

from selenium.webdriver.common.action_chains import ActionChains

driver = webdriver.Chrome()

driver.get("http://www.baidu.com")

#鼠标移动至图片上 右键保存图片

elem_pic = driver.find_element_by_xpath("//div[@id='lg']/img[1]")

print(elem_pic.get_attribute("src"))

action = ActionChains(driver).move_to_element(elem_pic).context_click(elem_pic)

#重点:当右键鼠标点击键盘光标向下则移动至右键菜单第一个选项

action.send_keys(Keys.ARROW_DOWN)

time.sleep(3)

action.send_keys('v') #另存为

action.perform()四:填充表单

对于下拉菜单(Select)的操作,Selenium有专门的类Select进行处理。

页面HTML源码如下所示:

1.Select提供了三种选择方法:

select_by_index(index) #通过选项的顺序,第一个为 0

select_by_value(value) #通过value属性

select_by_visible_text(text) #通过选项可见文本2.Select提供了四种方法取消选择:

deselect_by_index(index)

deselect_by_value(value)

deselect_by_visible_text(text)

deselect_all()3.Select提供了三个属性方法提供信息:

options #提供所有的选项的列表,其中都是选项的WebElement元素

all_selected_options #提供所有被选中的选项的列表,其中也均为选项的WebElement元素

first_selected_option #提供第一个被选中的选项,也是下拉框的默认值通过Select提供的方法和属性,我们可以对标准select下拉框进行任何操作,但是对于非select标签的伪下拉框,需要使用XPath定位;

4.示例

from selenium import webdriver

from selenium.webdriver.common.action_chains import ActionChains

from selenium.webdriver.support.select import Select

import time

driver = webdriver.Chrome()

driver.get("https://www.baidu.com/")

driver.implicitly_wait(20)

mouse = driver.find_element_by_link_text("设置")

ActionChains(driver).move_to_element(mouse).perform()

driver.find_element_by_link_text("搜索设置").click()

time.sleep(2)

# 实例化select

s = Select(driver.find_element_by_id("nr"))

# 定位选项

s.select_by_value("20") # 选择value="20"的项:通过value属性

time.sleep(2) #为了明显的看出变化

s.select_by_index(0) # 选择第一项选项:通过选项的顺序选择,第一个为 0

time.sleep(2) #为了明显的看出变化

s.select_by_visible_text("每页显示50条") # 选择text="每页显示50条"的值,即在下拉时我们可以看到的文本五:弹窗处理

弹出框有两种:页面弹出框(可定位元素能操作)、Windows弹出框(不能直接定位)

1.页面弹出框

等待弹出框出现之后,定位弹出框,操作其中元素

driver = webdriver.Chrome()

driver.get("https://www.baidu.com")

driver.maximize_window()

#点击百度登录按钮

driver.find_element_by_xpath('//*[@id="u1"]//a[@name="tj_login"]').click()

#等待百度登录弹出框中 要出现的元素可见

ele_id = "TANGRAM__PSP_10__footerULoginBtn"

param = (By.ID,ele_id)

#元素可见时,再进行后续操作

WebDriverWait(driver,10).until(EC.visibility_of_element_located(param))

driver.find_element_by_id(ele_id).click()

time.sleep(5)

driver.quit()2.Windows弹出框

使用 driver.switch_to.alert 切换到Windows弹出框,Alert类提供了一系列操作方法:

accept() #确定

dismiss() #取消

text() #获取弹出框里面的内容

send_keys(keysToSend) #输入字符串#1:定位alert弹出框

#点击页面元素,触发alert弹出框

driver.find_element_by_xpath('//*[@id="alert"]').click()

time.sleep(3)

#等待alert弹出框可见

WebDriverWait(driver,20).until(EC.alert_is_present())

#从html页面切换到alert弹框

alert = driver.switch_to.alert

#获取alert的文本内容

print(alert.text)

#接受--选择“确定”

alert.accept()

#2:定位confirm弹出框

driver.find_element_by_xpath('//*[@id="confirm"]').click()

time.sleep(3)

WebDriverWait(driver,20).until(EC.alert_is_present())

alert =driver.switch_to.alert

print(alert.text)

# 接受--选择“取消”

alert.dismiss()

#3:定位prompt弹出框

driver.find_element_by_id("prompt").click()

time.sleep(3)

WebDriverWait(driver,20).until(EC.alert_is_present())

alert =driver.switch_to.alert

alert.send_keys("jaja")

time.sleep(5)

print(alert.text)

# alert.dismiss()

alert.accept()六:页面切换

在打开新的浏览器窗口时,如果要定位新窗口的元素,需要先切换到这个新打开的窗口中,才能定位到该窗口下的元素。

1.获取当前句柄

current_window_handle:获取当前句柄。可以把句柄理解成窗口的身份证

2.获取所有打开窗口的句柄

window_handles:获取所有打开窗口的句柄

from selenium import webdriver

import time

dr = webdriver.Chrome()

dr.get('https://www.baidu.com')

# dr.maximize_window()

win_handle = dr.current_window_handle#获取当前窗口句柄

print(win_handle)

js = 'window.open("http://news.baidu.com")'#js打开新窗口

dr.execute_script(js)#执行js

handles = dr.window_handles#获取所有窗口句柄

for i in handles:

if i != win_handle:#如果句柄不是当前窗口的句柄

dr.switch_to.window(i)#切换窗口

ww = dr.find_element_by_id('ww')#新闻页面的搜索输入框

ww.send_keys('selenium')

time.sleep(2)

dr.switch_to.window(win_handle)#切换到百度首页的句柄

tr = dr.find_element_by_id('kw')#百度首页搜索框

tr.send_keys('selenium')

这是打印出来的句柄

因为使用WebDriver点击百度新闻不会新打开一个页面,所以就通过js来模拟打开一个新网页了。通过循环所有句柄,当句柄不是当前窗口的句柄,就切换到这个窗口去。

from selenium import webdriver

import time

dr = webdriver.Chrome()

dr.get('https://www.baidu.com')

dr.maximize_window()

js = 'window.open("http://news.baidu.com")'

dr.execute_script(js)

handles = dr.window_handles#获取所有窗口句柄

dr.switch_to.window(handles[1])

ww = dr.find_element_by_id('ww')#新闻页面的搜索输入框

ww.send_keys('selenium')

time.sleep(2)

dr.switch_to.window(handles[0])

tr = dr.find_element_by_id('kw')#百度首页搜索框

tr.send_keys('selenium')

dr.quit()所有窗口句柄是一个数组,可以通过数组的下标来访问相应的句柄,默认是按照打开窗口的顺序存的。

本博客所有文章除特别声明外,均采用 CC BY-SA 4.0 协议 ,转载请注明出处!